Warum Peer-Review? Der Peer-Review soll mögliche Probleme mit der wissenschaftlichen Qualität einer Veröffentlichung, etwa Fehler in der Statistik, Ungereimtheiten und fragwürdige Schlussfolgerungen, aufdecken.

Dies ist der 22. Beitrag einer Blogserie zu einer Zusammenstellung von „Schlüsselkonzepten zur besseren Bewertung von Aussagen zu Behandlungen“, die im Rahmen des Informed Health Choices Projektes erarbeitet wurden. Jeder der insgesamt 36 Blogbeiträge befasst sich mit einem der Schlüsselkonzepte, die als wichtig dafür erachtet werden, Aussagen zu Wirkungen von Behandlungen besser verstehen und einordnen zu können.

Veröffentlichungen in Peer-Review-Zeitschriften werden von unabhängigen Experten* des gleichen Fachgebiets begutachtet. Ein Peer-Review kann sowohl vor als auch nach der Veröffentlichung stattfinden, wobei der Review vor der Veröffentlichung in der akademischen Welt als Standardverfahren gilt. Das Konzept der Peer-Reviews stammt bereits aus dem Jahr 1731, als die Royal Society of Edinburgh eine Mitteilung folgenden Inhalts verbreitete [1]:

„Schriftlich eingesandte Beiträge werden je nach Thematik an jene Mitglieder verteilt, die in der Materie am besten bewandert sind. Ihre Identität wird dem Autor nicht bekanntgegeben“.

Heute ist der Peer-Review zentraler Bestandteil der Qualitätskontrolle und wesentliche Grundlage eines funktionierenden Wissenschaftsbetriebs. Die Royal Society, nationale Akademie der Wissenschaften des Vereinigten Königreichs, bemerkt dazu nicht ohne Stolz [2]:

„Peer-Review ist für die Führung des Wissenschaftsbetriebs, was die Demokratie für die Führung des Landes ist“.

Wie funktioniert Peer-Review?

Wie funktioniert Peer-Review?

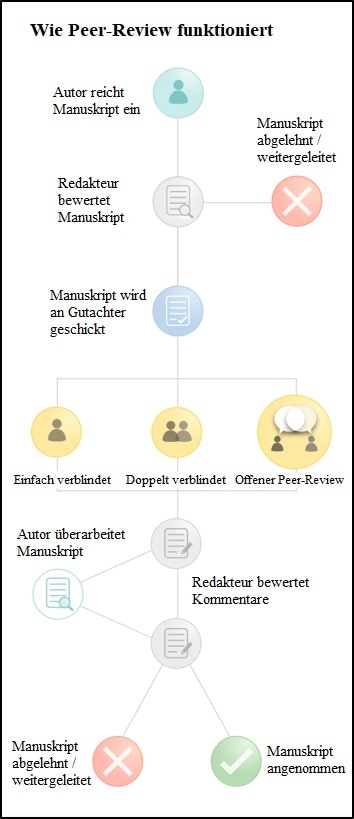

Peer-Reviews werden in den einzelnen Zeitschriften sehr unterschiedlich gehandhabt; ein allgemeingültiges Verfahren gibt es nicht. Eine Zusammenfassung des gängigen Vorgehens ist in Abbildung 1 dargestellt. Es gibt drei Hauptarten von Peer-Reviews, die von der Royal Society of Edinburgh beschrieben werden [3]:

1. Single-blind Review (Einfachblindgutachten)

Am häufigsten in medizinischen Fachzeitschriften: Autor und Institution sind dem Gutachter bekannt, Autoren gegenüber bleibt der Gutachter aber anonym

Beispiel: New England Journal of Medicine (NEJM)

2. Double-blind Review (Doppelblindgutachten)

Weder Autor noch Gutachter kennen einander, nur der Redakteur kennt deren Identität

Beispiel: Medical Journal of Australia (MJA)

3. Offener Review

Autoren und Gutachter kennen einander

Beispiel: British Medical Journal (BMJ)

Abbildung 1. Zusammenfassung des gängigen Verfahrens beim Peer-Review [4]

Kann es im Zusammenhang mit Peer-Reviews zu Verzerrungen (Bias) kommen?

Peer-Reviews sind keineswegs perfekt. Das Verfahren ist, wie das Meiste in der Forschung, anfällig für Bias. Evidenz ist nicht automatisch allein deswegen zuverlässig, weil sie aus einem Peer-Review-Artikel stammt.

Zum Beispiel gibt es Belege für eine oftmals schlechte Übereinstimmung der Beurteilungen zwischen verschiedenen Peer-Reviewern. So besteht ein erheblicher Bias gegen Manuskripte mit Forschungsergebnissen, die im Widerspruch zum theoretischen Standpunkt des Gutachters stehen [5]. Eine im Journal of General Internal Medicine vorgestellte Studie hat gezeigt, dass Gutachter bei ihren Empfehlungen zur Annahme oder Überarbeitung beziehungsweise der Ablehnung eines Manuskripts kaum häufiger übereinstimmten als man nach dem Zufallsprinzip erwarten würde; dennoch legen Herausgeber großen Wert auf die Empfehlungen von Gutachtern [6]. Darüber hinaus zeigte eine Studie, dass wissenschaftliche Aufsätze mithilfe zahlreicher öffentlicher Reviews nach der Veröffentlichung durch Leser besser begutachtet wurden, als durch eine kleine Gruppe von Experten [7].

Auch die Verzerrung durch Gutachterpräferenzen („Reviewer Bias“) im einfach verblindeten Peer-Review-Verfahren ist Gegenstand anhaltender Diskussionen. Wenn den Gutachtern die Identität der Verfasser bekannt ist, können nach Auffassung von Kritikern indirekter Bias gegen Frauen [8] und Autoren mit ausländischen Nachnamen oder von weniger renommierten Institutionen [9] auftreten. Aus diesem Grunde halten einige Forscher doppelt verblindete Peer-Reviews für das bessere Verfahren.

Ein anderer Einwand bezieht sich auf multidisziplinäre Artikel: Gutachter, die in allen entsprechenden Disziplinen bewandert sind, sind schwer zu finden. Die Behandlung mehrerer verschiedener Themen in einer einzelnen Studie ist meist ein Nachteil für die Autoren solcher Arbeiten [3].

Wenn der Peer-Review versagt – Beispiele aus der Vergangenheit

Unabhängig davon, welches Review-System verwendet wird oder welche potenziellen Verzerrungen es erzeugen könnte, besteht immer die Möglichkeit, dass größere oder kleinere Fehler übersehen werden:

1. Impfungen und Autismus

Hier geht es um den wohl bekanntesten jemals zurückgezogenen Zeitschriftenartikel der Wissenschaftsgeschichte. In The Lancet stellte Andrew Wakefield 1998 eine kleine Studie vor, die zu zeigen schien, dass MMR-Impfungen gegen Masern, Mumps und Röteln Autismus auslösen könnten. Wie sich herausstellte, wählte Wakefield aus nicht offengelegtem finanziellem Interesse selektiv Teilnehmer aus und manipulierte Diagnosen und Krankheitsgeschichten [11]. Wakefields Aufsatz führte dazu, dass sich weniger Menschen impfen ließen und dadurch zu einem Anstieg von Masern, Mumps und Röteln. Vermehrte schwere Krankheitsverläufe und einige Todesfälle waren die Folge.

2. Peer-Review im Test: Vorsätzliche Fehler

2008 platzierten Forscher in einem demnächst zu veröffentlichenden 600 Wörter langen Studienbericht des British Medical Journal vorsätzlich acht Fehler und verschickten ihn an 300 Gutachter [12]. Die mittlere Anzahl der entdeckten Fehler betrug zwei. Zwanzig Prozent der Gutachter fanden überhaupt keine Fehler. Übersehen wurden gravierende Fehler wie methodische Schwächen, unrichtige Datenberichterstattung, ungerechtfertigte Schlussfolgerungen ebenso wie geringfügige Fehler wie Auslassungen und unrichtige Datenberichterstattung [13].

3. COOPERATE-Studie

In der COOPERATE-Studie wurde die Therapie mit einem Angiotensin-Konversionsenzym-Hemmer und einem Angiotensin-II-Rezeptorblocker untersucht. Das Ergebnis war, dass eine Kombination beider Medikamente bei nicht-diabetischen Nierenerkrankungen besser wirkte als die Monotherapie [14]. Diese Studie wurde 2003 in The Lancet veröffentlicht und nach der Aufdeckung gravierender Mängel zurückgezogen. Im Gegensatz zu den Aussagen im Bericht war die Studie nie von einer Ethikkommission genehmigt worden, der Hauptautor hatte falsche Angaben über die Einholung der informierten Einwilligung gemacht, die Beteiligung eines Statistikers konnte nicht nachgewiesen werden, die Behandlung war nicht doppelt verblindet, da der Hauptautor das Zuteilungsschema kannte und die Kommission konnte die Echtheit des vom Hauptautor erstellten Datensatzes nicht feststellen [15].

Was können wir tun?

Man kann das Peer-Review-Verfahren zwar nicht gerade dafür verantwortlich machen, dass einige dieser Fehler übersehen wurden, beispielsweise die Datenmanipulation durch Wakefield oder die falschen Angaben des COOPERATE-Hauptautors über die Zustimmung der Ethikkommission. Dennoch konfrontieren diese Fälle uns mit der Tatsache, dass ein Peer-Review noch keine Garantie für Zuverlässigkeit ist. Einiges liegt außerhalb unserer Kontrolle, aber es gibt auch einiges, was wir tun können:

1. Den Artikel, insbesondere den Methodenteil, kritisch bewerten

Lesen Sie nicht nur den Abstract oder die wichtigsten Ergebnisse. Lesen Sie den Aufsatz von Anfang bis Ende durch, besonders den Methodenteil. Bewerten Sie den Aufsatz selbst, mithilfe anderer Blog-Artikel aus unserer „Schlüsselkonzepte“-Serie. Fragen Sie sich: Welche Merkmale könnten zu Verzerrungen führen? Und, genauso wichtig: Welche fehlenden Merkmale, die nicht erwähnt wurden, aber erwähnt werden sollten, könnten zu Verzerrungen führen?

Die kritische Bewertung und die Einschätzung des Verzerrungsrisikos sind Kompetenzen, die sich nicht über Nacht aneignen lassen. Eine Hilfe zur Vereinfachung und Strukturierung kritischer Bewertungen bieten Instrumente zur Bewertung von systematischen Übersichtsarbeiten („Critical Appraisal Tools“, CATs) oder Checklisten, wie z. B. vom Critical Appraisal Skills Programme (CASP) UK, Scottish Intercollegiate Guidelines Network (SIGN) oder dem Centre for Evidence-Based Medicine (CEBM). Auch die Leitlinien des EQUATOR network, die mit praktischen Checklisten für alle Studiendesigns eine akkurate und transparente Berichterstattung fördern, können eine nützliche Ressource sein. Die Autoren von Students 4 Best Evidence haben eine Liste dieser CATs und anderer international verbreiteter Hilfen zusammengetragen, die Sie unter diesem Link finden. Man sollte sich bewusst sein, dass diese Instrumente ebenfalls zu Verzerrungen führen können; dennoch sind sie ein guter Ausgangspunkt, wenn man sich näher mit der Bewertung von Evidenz beschäftigen will.

2. Eine gesunde Skepsis bewahren

Wir glauben nicht alles, was im Internet steht oder was im Fernsehen gezeigt wird. Dementsprechend sollten wir Informationen auch dann kritisch bewerten können, wenn sie in einer bedeutenden Fachzeitschrift wie NEJM oder Lancet veröffentlicht werden. Nicht das Ansehen der Zeitschrift zählt, sondern die Qualität des Textes – die Sie selbst einschätzen können. Wollen wir lieber einen funktionsfähigen Hyundai aus zweiter Hand oder einen Lamborghini ohne Räder? Vielleicht sollte der Satz lauten: Beurteile einen wissenschaftlichen Aufsatz nicht nach der Zeitschrift, in der er steht.

Fazit

Redaktionelles Peer-Review bleibt ein Eckpfeiler der wissenschaftlichen medizinischen Forschung [16] und fördert nach allgemeiner Auffassung eine bessere Qualität von Forschungsberichten. Untersuchungen zur Qualität medizinischer Forschungsberichte verdeutlichen allerdings, dass der Peer-Review keine Garantie für eine adäquate Berichterstattung von Forschungsergebnissen ist. Cochrane-Reviews der Forschung zur Effektivität von Peer-Reviews zeigen außerdem, dass das Verfahren nicht die Ergebnisse liefert, die ihm gemeinhin zugeschrieben werden. Wir sollten Aufsätze deshalb selbst kritisch bewerten. Das erhöht die Chance, Fehler aufzuspüren, die beim Peer-Review-Verfahren übersehen wurden.

Text: Dennis Neuen

Übersetzt von: Katharina Jones

Zum Originaltext

*Aus Gründen der besseren Lesbarkeit wird auf die gleichzeitige Verwendung männlicher und weiblicher Sprachformen verzichtet. Sämtliche Personenbezeichnungen gelten gleichermaßen für alle Geschlechter.